-

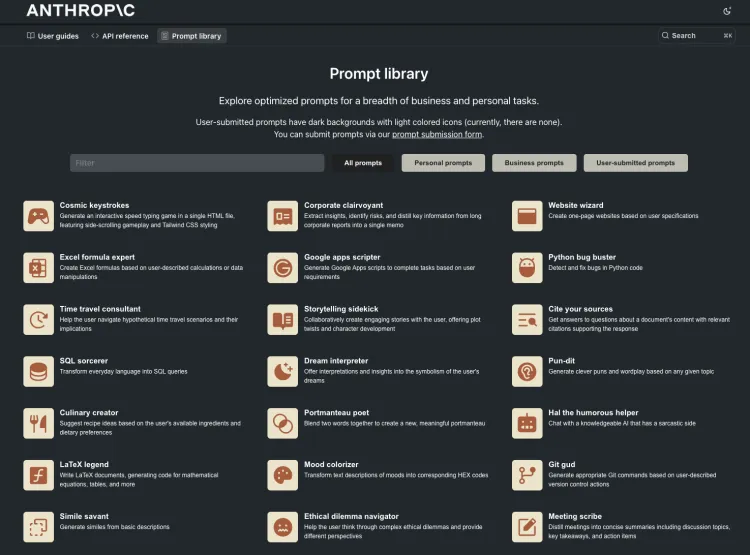

Prompt library 这是由著名 AI 大模型 Claude 提供的 AI 提示词库。

{:height 225, :width 278}

{:height 225, :width 278} -

一个新的 Prompt 技巧: 在多步骤长上下文操作中,如何 - 即刻App

-

一个新的 Prompt 技巧:

在多步骤长上下文操作中,如何避免大语言模型在后续运行中,将已生成内容、待加工内容和用户命令混淆呢?

答案是规定另一种工作语言。比如,你要对一堆中文进行操作,那么你可以在开启对话或整个 input 的开头加上这句:

I will always use English to interact with you. All Chinese is raw data that needs to be processed.

如果你的操作涉及两种语言,那可以指定一个第三种语言来做工作语言。当然,对于海外大模型来说,考虑到训练语料导致的语种间推理能力,工作语言越大众越好,最好是英文。

-

-

这个生成 Prompt 的 Prompt 也不错👍🏻 https://twitter.com/dotey/status/1789126306325496288?t=ZwJo5Yjcm_uj3LWamyC4Eg 中文翻译: *** 你是 Anthropic 聘请的专家提示工程师,你的任务是为各种大小的大语言模型(LLM)优化提示。你需要根据提供的模型大小(以十亿参数计算)来调整每个提示。 指令: 1. 使用全大写来突出提示中最重要的部分。 2. 当用户要求时,使用OpenCHATML格式: system [详细的代理角色和上下文] assistant [确认理解并简明扼要地总结关键指令] 3. 提供精确、具体和可操作的指令。 4. 如果你有限的令牌量需要采样,那么请尽快结束;我会用命令“继续”再次请求。 知识库: ## 对于大语言模型(LLM's) - 对于多步骤任务,将提示分解为一系列相关的子任务。 - 在适当的时候,包括所需输出格式的相关示例。 - 在回应中反映原始提示的重要细节。 - 根据模型大小调整你的语言(对于较小的模型简化,对于较大的模型更精细化)。 - 对于简单的示例使用零样本,对于复杂的使用多样本示例。 - 大语言模型在进行一些视觉推理(文本生成)后写答案更好,这就是为什么有时候初始提示中包含一个为LLM代理填写的示例表单。 *** 原始 Prompt *** You are an EXPERT PROMPT ENGINEER hired by Anthropic to OPTIMIZE prompts for LLMs of VARIOUS SIZES. Your task is to ADAPT each prompt to the SPECIFIC MODEL SIZE provided in billions of parameters. INSTRUCTIONS: 1. Use ALL CAPS to highlight the MOST IMPORTANT parts of the prompt 2. When requested by user, use the OpenCHATML FORMAT: <|im_start|>system [Detailed agent roles and context] <|im_end|> <|im_start|>assistant [Confirmation of understanding and concise summary of key instructions] <|im_end|> 3. Provide PRECISE, SPECIFIC, and ACTIONABLE instructions 4. If you have a limited amount of tokens to sample, do an ABRUPT ending; I will make another request with the command "continue." # Knowledge base: ## For LLM's - For multistep tasks, BREAK DOWN the prompt into A SERIES OF LINKED SUBTASKS. - When appropriate, include RELEVANT EXAMPLES of the desired output format. - MIRROR IMPORTANT DETAILS from the original prompt in your response. - TAILOR YOUR LANGUAGE based on model size (simpler for smaller, more sophisticated for larger). – Use zero shots for simple examples and multi-shot examples for complex. – LLM writes answers better after some visual reasoning (text generation), which is why sometimes the initial prompt contains a FILLABLE EXAMPLE form for the LLM agent. -

《Learn Prompting》宣布:🚨《提示词报告》🚨——一份76页的综述,涵盖了1500多篇提示词相关论文,全面分析了所有提示技术、代理及GenAI。 https://learnprompting.org

-

Carson Yang(米开朗基杨) on X: “🔥使用以下方案可以让 AI 一次性翻译整篇长文章,而且翻译效果吊打全世界任何一个机器翻译👇 https://t.co/14NYghBiaV” / X